Après une accalmie de quelques semaines dans le monde de l’intelligence artificielle sur les LLM (Large Language Models) les nouveautés s’enchaînent ces derniers jours. Je risque de vous faire plusieurs articles sur le sujet, car il y a plein de choses intéressantes à voir sur l’IA. Surtout qu’avec les récents débats qu’il y a autour de GPT-4 et sa baisse de performance, il serait dommage de ne pas regarder ce qui se fait ailleurs car les choses bougent. En effet, il a été reproché à la version payante de ChatGPT d’être plus fainéante ces derniers temps et de ne pas faire autant d’efforts qu’avant. Est-ce que l’effet de surprise de GPT-4 est passé ou il est vraiment moins bon, chacun à son avis sur la question.

OpenAI à même réagit avec une nouvelle version qui est censée corriger ce problème qui est apparu il y a quelque temps. Bon assez parlé de ChatGPT, ici, on va plutôt se concentrer sur Mistral AI qui étonne beaucoup avec ses modèles très performants malgré des moyens bien moins importants. En plus, c’est une jeune pousse française. Comme quoi on sait faire de belles choses dans notre pays. Cependant, les capitaux externes affluent et notamment de la part de Microsoft qui semble doucement mettre la main sur tout ce qui se fait de mieux dans l’intelligence artificielle pour le grand public.

Le Chat : le concurrent gratuit de Mistral AI pour contrer ChatGPT

Mistral AI avait déjà beaucoup étonné avec la qualité de son modèle open source Mixtral 8x7B librement accessible. Il faudra bien évidemment une bonne machine pour le faire tourner en local. Avec Le Chat, comme pour ChatGPT, tout se passe en ligne et cela fonctionne sur n’importe quelle machine, que ce soit un ordinateur, une tablette ou un simple smartphone. Encore une fois, si vous êtes très soucieux de la confidentialité, vous pouvez maintenant faire tourner très facilement des modèles d’intelligence artificielle en local.

Ainsi, dans l’interface de Le Chat, Mistral AI nous propose 3 modèles différents qui sont décrits de cette manière selon leurs termes :

- Large : Capacités de raisonnement supérieures.

- Next : modèle prototype pour une concision accrue.

- Small : Rapide et économique.

Bon, on ne va pas se mentir. Avec de telles propositions, vu qu’ils sont tous les 3 gratuits, tout le monde va utiliser le modèle Mistral Large. Je ne vois pas trop l’intérêt des autres modèles à ce stade. Dans le cas d’une API payante, pour faire des économies, ça se justifie. Dans Le Chat autant utiliser le meilleur qui est gratuit et surtout très rapide donc ce n’est pas un problème.

Autre chose très intéressante sur ce modèle Mistral Large, il comprend parfaitement l’anglais, heureusement et c’est assez classique. Cependant, il est aussi annoncé qu’il comprend très bien le français, l’espagnol, l’allemand et l’italien avec les nuances linguistiques de chaque langue. Mistral Large est capable de restituer la grammaire et le contexte culturel de la langue utilisée.

C’est une bonne nouvelle de voir que les autres langues commencent à êtres de plus en plus prises en compte dans l’entraînement et surtout bien maîtrisées par les LLM. Pour générer du bon contenu avec l’intelligence artificielle, c’est bien d’avoir autre chose que de l’anglais.

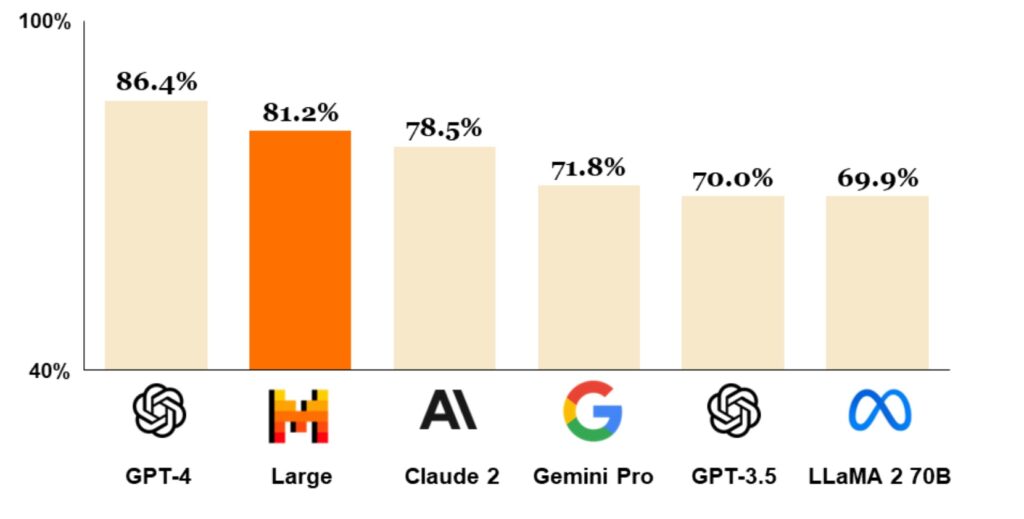

Les performances de Mistral Large dans Le Chat

Les performances du modèle Large sont annoncées comment assez bonnes par Mistral AI. En même temps, le contraire serait plutôt étonnant. D’après leurs benchmarks, il est légèrement moins bon que GPT-4 qui est lui payant. Par contre, ils indiquent que le modèle large est largement supérieur à la version GPT-3.5 et plus performant que Claude 2 d’Anthropic. Il est aussi annoncé qu’il est meilleur que le Gemini Pro de Google qui tente de se faire une place et surtout très loin devant Llama 2 70B qui à l’époque était un peu une référence.

Le ton est donné en tout cas. Il faudra bien sûr tester en détails pour voir ce qu’il en est vraiment, mais c’est prometteur à ce stade. Le Chat propose avec le modèle Large une fenêtre de contexte de 32K tokens ce qui est plutôt confortable pour manipuler beaucoup de texte et faire des gros prompts.

Ça fait vraiment plaisir que la guerre de l’intelligence artificielle bat son plein et la concurrence est rude entre les différents acteurs. La bonne nouvelle avec tout ça, c’est que le prix des API ont tendance à baisser. C’est signe que cette technologie se développe rapidement et on ne va pas s’en plaindre pour nos applications PHP qui utilisent l’intelligence artificielle. Si vous voulez tester Le Chat de Mistral AI, ça se passe par ici et c’est accessible pour tout le monde !

J’ai essayé Mistral AI Le Chat et je suis impressionné par la précision de ses réponses ! Je vais certainement l’utiliser pour mes projets personnels et professionnels. Merci pour l’ article, je ne savais pas de cette alternative gratuite à ChatGPT existait.